一、robots基本概念

robots.txt文件是网站的一个文件,它是给搜索引擎蜘蛛看的。搜索引擎蜘蛛爬行道我们的网站首先就是抓取这个文件,根据里面的内容来决定对网站文件访问的范围。它能够保护我们的一些文件不暴露在搜索引擎之下,从而有效的控制蜘蛛的爬取路径,为我们站长做好seo创造必要的条件。尤其是我们的网 站刚刚创建,有些内容还不完善,暂时还不想被搜索引擎收录时。

几点注意:

网站必须要有一个robot.txt文件。

robots.txt文件应该放置在网站根目录下

文件名是小写字母。

当需要完全屏蔽文件时,需要配合meta的robots属性。

二、robots.txt的基本语法

内容项的基本格式:键: 值对。

1) User-Agent键

后面的内容对应的是各个具体的搜索引擎爬行器的名称。如百度是Baiduspider,谷歌是Googlebot。

一般我们这样写:

User-Agent: *

表示允许所有搜索引擎蜘蛛来爬行抓取。如果只想让某一个搜索引擎蜘蛛来爬行,在后面列出名字即可。如果是多个,则重复写。

注意:User-Agent:后面要有一个空格。

在robots.txt中,键后面加:号,后面必有一个空格,和值相区分开。

2)Disallow键

该键用来说明不允许搜索引擎蜘蛛抓取的URL路径。

例如:Disallow: /index.php 禁止网站index.php文件

Allow键

该键说明允许搜索引擎蜘蛛爬行的URL路径

例如:Allow: /index.php 允许网站的index.php

通配符*

代表任意多个字符

例如:Disallow: /*.jpg 网站所有的jpg文件被禁止了。

结束符$

表示以前面字符结束的url。

例如:Disallow: /?$ 网站所有以?结尾的文件被禁止。

三、robots.txt实例分析

例1. 禁止所有搜索引擎访问网站的任何部分

User-agent: *

Disallow: /

例2. 允许所有的搜索引擎访问网站的任何部分

User-agent: *

Disallow:

例3. 仅禁止Baiduspider访问您的网站

User-agent: Baiduspider

Disallow: /

例4. 仅允许Baiduspider访问您的网站

User-agent: Baiduspider

Disallow:

例5. 禁止spider访问特定目录

User-agent: *

Disallow: /cgi-bin/

Disallow: /tmp/

Disallow: /data/

注意事项:1)三个目录要分别写。2)请注意最后要带斜杠。3)带斜杠与不带斜杠的区别。

例6. 允许访问特定目录中的部分url

我希望a目录下只有b.htm允许访问,怎么写?

User-agent: *

Allow: /a/b.htm

Disallow: /a/

注:允许收录优先级要高于禁止收录。

从例7开始说明通配符的使用。通配符包括("$" 结束符;

"*"任意符)

例7. 禁止访问网站中所有的动态页面

User-agent: *

Disallow: /*?*

例8. 禁止搜索引擎抓取网站上所有图片

User-agent: *

Disallow: /*.jpg$

Disallow: /*.jpeg$

Disallow: /*.gif$

Disallow: /*.png$

Disallow: /*.bmp$

其他很多情况呢,需要具体情况具体分析。只要你了解了这些语法规则以及通配符的使用,相信很多情况是可以解决的。

四、meta robots标签

meta是网页html文件的head标签里面的标签内容。它规定了此html文件对与搜索引擎的抓取规则。与robot.txt 不同,它只针对写在此html的文件。

写法:

。

…里面的内容列出如下

noindex - 阻止页面被列入索引。

nofollow - 阻止对于页面中任何超级链接进行索引。

noarchive - 不保存该页面的网页快照。

nosnippet - 不在搜索结果中显示该页面的摘要信息,同时不保存该页面的网页快照。

noodp - 在搜索结果中不使用Open Directory Project中的描述信息作为其摘要信息

SEO专题推荐:

关键词优化专题:网站关键词优化没效果?来这里学习最实用的关键词优化技巧!

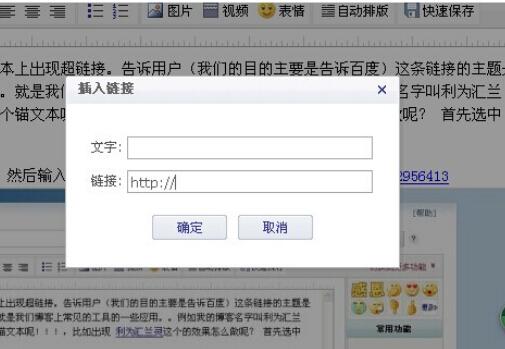

内链优化专题:最能提升网站权重的内链部署优化技巧与方法

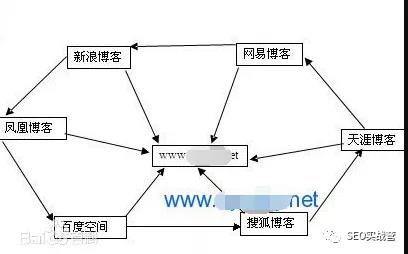

外链建设专题:高质量自然外链怎么做?读完这些你将质的飞跃

网站降权专题:2015年最有用的网站降权、被K、被黑、被攻击的解决方法

用户体验专题:学习完这些,作为站长的你可以秒懂如何做网站用户体验

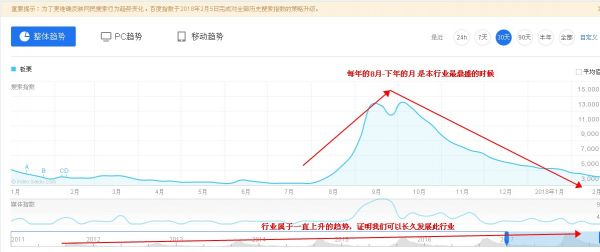

行业网站专题:优化行业网站的“葵花宝典”看完后无优化压力

申请创业报道,分享创业好点子。点击此处,共同探讨创业新机遇!