SEOer一般都会动手为自己搭建一个网站,一般以个人博客类为主流。对于刚刚入行的SEOer来说,搭建个人博客的目的大致相同。一方面是作为学*结经验使用,也就是拿来练练手,熟悉作业学习经验;一方面也是想能够把关键词优化上首页,从而获取流量并最终达到获取利益的结果。但不管出于何种目的,新网站搭建完毕之后首要面临的就是收录问题。那么,新网站上线之后如何实现快速收录呢?下面,笔者就个人的一些经验为大家做出分享。

网站快速收录

笔者入行从事SEO优化工作已经有几年时间,搭建过的网站不敢用多不胜数来形容,但绝对也是不少的了。就笔者的以往的经验总结,收录的快与慢,无非是蜘蛛的爬行量(此处的量具有双语义,指的是质量和数量)的多与寡问题。这里可能大家有个疑问,蜘蛛不都是一样的吗?怎么还有质量优劣之分?这个问题笔者就不在这里解释了。大家可以百度去了解一下。

回到主题,如何提高新站上线后快速收录问题。很多人都在说提高收录的技巧和方法,网上去搜,也可以找到很多的方法论和技巧论之类的帖子。对于这些帖子讲解的方法是否有效,笔者不多做评论。今天这篇文章也不是要教大家提高快速收录的方法,而是告诉大家为什么能够提高快速收录。只有理解透彻收录的原理,才能够找到有效的提高收录的方法。毕竟网上提供的方法都是别人提供的,这些方法和技巧也许真的有用,很可能是前辈们的智慧结晶。但到今时今日,是否依旧仍有可行性,还需自己去检验真理。

说了这么多,如果读者觉得自己已经懂了这些基础理论的知识,或者是觉方法技巧比理论更重要的,可以直接忽略下文。因为在笔者看来,没有扎实的理论基础,就无法有精妙的SEO优化技巧和方法的诞生。只知道拾取别人用的东西而不去实现自主创造的SEOer,永远也不会成为SEO大神。所以,如果读者依旧想要技巧和方法,放弃阅读下文吧。

以下是笔者对搜索引擎蜘蛛爬行原理的一些浅薄见知,写来供大家作个参考,如果有不同见解可以在下方留言,还请诸君不要吝啬指教一番。来看看搜索引擎蜘蛛蜘蛛是如何作业的原理吧?

从事SEO工作的应该都清楚,一个网页想要被收录,就必须有蜘蛛过来爬行,只有蜘蛛过来爬行,你的网站才有可能被搜索引擎收录。那么,蜘蛛是怎么爬行的呢?他的爬行习惯是怎样的呢?

原理

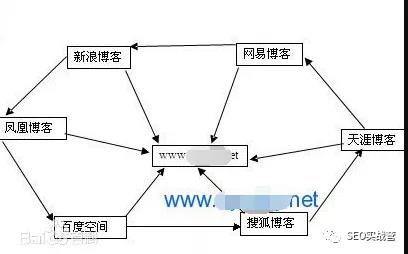

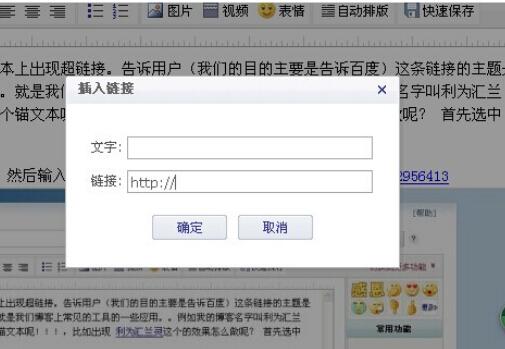

搜索引擎蜘蛛通过url链接爬行到达网页页面,按照从上到下,从左到右的习惯对网页内容爬行抓取,然后通过链接爬行进行到另一个页面,按照从上到下,从左到右爬行抓取,如此重复。那么,既然蜘蛛是通过链接爬行抓取页面信息的,是不是只要把网站上线了就一定会被爬行抓取呢?答案是:未必。想要正常访问网站进行抓取,还需具备以下几个条件:

服务器

想要能够正常的访问网站,首先要保证服务器的稳定性。网站就好比是搭建在地面上的楼房,而服务器就是承载楼房的地基。没有牢固结实的地基,那么建立在其上的楼房就有随时倒塌的危险。如果服务器不稳定,蜘蛛在抓取的时候就随时有可能面临楼房坍塌的危险,就会导致爬行抓取失败,对这样的网站蜘蛛是非常不友好的。

域名

新域名一般是不会有问题的,但如果使用的域名是老域名就必须无任何不良记录,如果域名被计入黑名单,有过作弊行为,被k过,这样的域名来建站是很难被收录的。

协议

每一个网站就好像是站长自己的私密房间,既然是私密的,那么当有人要来拜访的时候就必须得遵守主人的协议了,至少也得先敲敲门、打声招呼吧。一样的道理,蜘蛛到达网站之后,首先也是要和网站打声招呼的,这个就是robots.txt协议了。每一个站长都必须在网站添加一份robots协议,告诉蜘蛛网站方不方便访问,如果是robots是禁止的写法,蜘蛛就不会再继续访问,如果是同意的写法,蜘蛛将按照协议进行爬行。虽然只是一份很简单的协议,却也是尤其重要的,这直接关系到网站能不能收录的问题,新站长们尤其要特别关注一下。至于robots的写法和坚持方法,网上有很多教程,大家自己去搜索一番即可得到想要的。

以上就是蜘蛛的爬行规则,了解了蜘蛛的爬行规则,我们再来看看哪些是对收录有帮助的。

内容

保证了蜘蛛能够正常访问和抓取的问题之后,自然是页面内容丰富的问题。一个网站如果没有任何内容,就算来再多的蜘蛛爬行,也抓取不到任何的信息,更加不会被收录。蜘蛛比较喜欢新鲜的原创性的文字内容,对于图片视频的抓取目前还是比较困难,所以对网站增加原创文章的方法是快速收录的不二之选。

HTML静态页面

笔者发现动态URL链接其实也是可以收录的,像很多的论坛链接都是动态的,收录一样不错。实际上动态页面是可以收录,只是相比较静态页面比较繁杂一些。相对而言,蜘蛛更加喜欢简洁的HTML页面,爬行抓取会更加轻松不费什么力气。

URL层级

层级优化很多人都建议三级栏目,即首页--栏目页--内容页。这样的层级是最简洁的,简洁简短的URL是受蜘蛛青睐的,会更加容易爬行。这里建议层级命名尽量简短好记,层级尽量缩短,减少蜘蛛爬行困难。当然并非是说一定要是三级层级,根据网站需求调整,笔者看到有一些网站也是四级栏目,收录也是挺好的,这并不是取决收录的唯一标准。

sitemap网站地图

顾名思义,网站地图就是站长为搜索引擎蜘蛛制作的一份网站URL链接爬行地图指南。有了这份地图,蜘蛛爬行会更新方便简单,不会出现迷路的情况,对网站也就会生出更多的好感。

看到这里,不知道读者们有无了解清楚,要如何做才能够提高网站的收录问题。想要新网站能够快速的被收录,就必须要了解收录的原理。从稳定的服务器,域名的选择,robots协议的正确写法等等,再到对网站内容、页面、层级、sitemap的优化,都是为了使网站能够得到搜索引擎蜘蛛的青睐,让更多的搜索引擎蜘蛛能够来爬行网站,这样才能提高网站的收录。

当然,除了以上笔者所提到的,还有更多是笔者未提高到。但这些都不是最重要的,方法总是有的,关键在于你能不能发现。笔者的新博客十豆口子搭建好上线到收录,也就不到一天的时间。所以,不要总想着一些所谓的黑帽黑科技,一些简单的优化思维,都胜过这些旁门左道。

申请创业报道,分享创业好点子。点击此处,共同探讨创业新机遇!