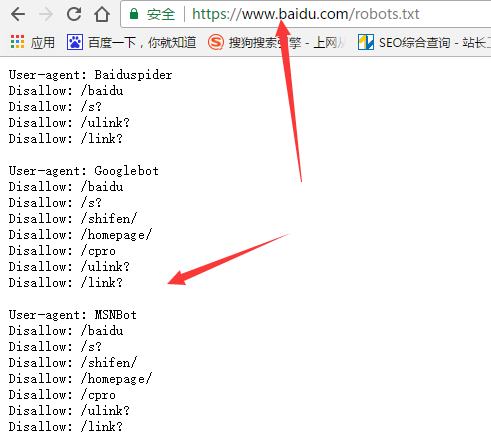

曾庆平SEO在前面的文章中讲过robots.txt概念的时候,留下一个问题:为什么曾庆平SEO的robots.txt写得那么复杂?

曾庆平SEO的robots.txt:http://www.***seo.com/robots.txt 这样做的目的是,让搜索引擎看来网站更规范和权威。

1、用robots.txt屏蔽相似的页面或没内容的页面。

我们知道,搜索引擎收录网页后,会对网页进行“审核”,当网页的相似度很高时2个页面,搜索引擎会删除其中一个。

假如以下这两个链接,内容其实差不多,所以第一个链接应该屏蔽。 http://www.xxx.com/bbs/redirect.php?tid=5167&goto=lastpost#lastposthttp://www.xxx.com/bbs/thread-5167-1-1.html

第一个的链接非常多,屏蔽时,只要屏蔽/bbs/redirect.php? 就屏蔽了所有的。代码如:Disallow: /bbs/redirect.php?

类似这样的页面,没有内容,也应该屏蔽:http://www.xxx.com/index.php?sid=247304&lang=zh&action=writecomment&id=77&artlang=zh 这样的链接也很多,屏蔽时,只要屏蔽/index.php?sid= 就屏蔽了所有的。

代码如:Disallow: /index.php?sid=

2、用robots.txt屏蔽多余的链接,当动态和静态共存时,一般去掉动态的。

网站中经常会存在多个链接指向同一个页面,这种情况普遍存在时,会让搜索引擎对网站的权威性产生怀疑。通过robots.txt把非主要的链接去掉。

假如以下两个链接指向同样的页面,去掉次要的第一个。

http://www.xxx.com/space.php?username=曾庆平seo

http://www.xxx.com/space-uid-15.html

代码如:Disallow: /space.php?username=

特别需要注意的是,首页一般有这么几个链接:www.yongfengseo.com www.yongfengseo.com/index.html 等,这个时候,不要屏蔽 index.html。因为如index.html index.php 等是默认首页,屏蔽可能导致蜘蛛爬取错乱。

咱们需要做的是,在给首页做站内外链接时,统一用不带index.html 的http://www.yongfengseo.com/ 即可。这是URL标准化的概念。

3、用robots.txt屏蔽死链接。

死链接就是原来存在,后来因为改版或更新等缘故删除了的链接和网页。比如,原来在某个目录(假设目录为/tempweb/)下的所有链接,因为改版现在都变为死链接了,可以用robots.txt屏蔽。

代码如:Disallow: /tempweb/

4、用robots.txt屏蔽可能存在的“被K”外部链接。

很多网站允许用户放自己的网站链接,但因为过多的“被K”外部链接可能连累自己。所以,很多把所有外部链接放入一个链接目录下,然后通过robots.txt统一屏蔽。

如果你对Disallow:的具体操作办法不是很清楚,你可以从这里了解我之前发布的robots文章。

本文来自微信公众号:平哥SEO优化(qingpingseo) 原文链接:http://www.yongfengseo.com

申请创业报道,分享创业好点子。点击此处,共同探讨创业新机遇!