Check Point:2026年AI 智能体 (AI Agent)安全启示

2025 年,被认为是 AI 智能体(AI Agent)真正走向规模化落地的一年。多家研究机构报告显示,2025 年中国 AI 智能体市场规模约为 69 亿元人民币,并有望在 2030 年接近 300 亿元;同时,Roland Berger 的报告指出,到 2025 年中国生成式 AI 用户规模已达到 2.5 亿人,用户基础正迎来爆发式增长。这意味着,AI 正从“技术创新工具”迅速转变为“生产系统基础设施”,智能体正在走入客服、办公自动化、数据分析、研发辅助以及业务流程自动化等核心场景。

当 AI 智能体开始具备“能理解、能决策、还能执行”的能力,它们所承载的不再只是对话交互,而是对业务流程、数据资产和系统权限的深度介入。也正是在这一阶段,安全问题开始从“模型是否安全”升级为“整个智能体体系是否可控”。

Check Point AI 智能体安全研究负责人 Mateo Rojas-Carulla 指出,我们正处于安全领域的关键拐点。Check Point 与Lakera 的数据显示,攻击者并没有坐等技术成熟,他们随时伺机而动,在 Agent 功能上线的第一时间就开始了精准猎杀。攻击者现在利用“系统提示词窃取”来获取 Agent 的底层逻辑,利用“良性伪装”绕过敏感词过滤,甚至通过在发票、文档中嵌入隐蔽指令来进行“间接注入”,借 Agent 之手执行恶意操作。同时,Check Point 与 Lakera 在研究中指出,一旦 AI 从静态语言模型演进为具备工具调用、文档访问和多步骤工作流能力的智能体系统,攻击面将发生本质变化。攻击者不再只针对模型输出本身,而是将目光投向系统逻辑、执行流程与外部数据接口。

从现实攻击案例来看,三类趋势尤为突出。

·首先,系统提示词正在成为新的高价值攻击目标。系统提示词定义了智能体的角色、权限边界和工作逻辑,一旦被泄露或操控,就相当于为攻击者提供了一份“操作说明书”。研究发现,攻击者往往通过构造假设性场景或伪装成开发、审计任务的方式,引导模型在无意中暴露内部规则。

·其次,内容安全绕过方式正在变得更加隐蔽。攻击者不再直接发起恶意请求,而是将有害内容包装为“分析”“评估”“总结”等看似合理的任务。传统基于关键词和规则的过滤体系,在这种语境重构面前往往难以奏效。

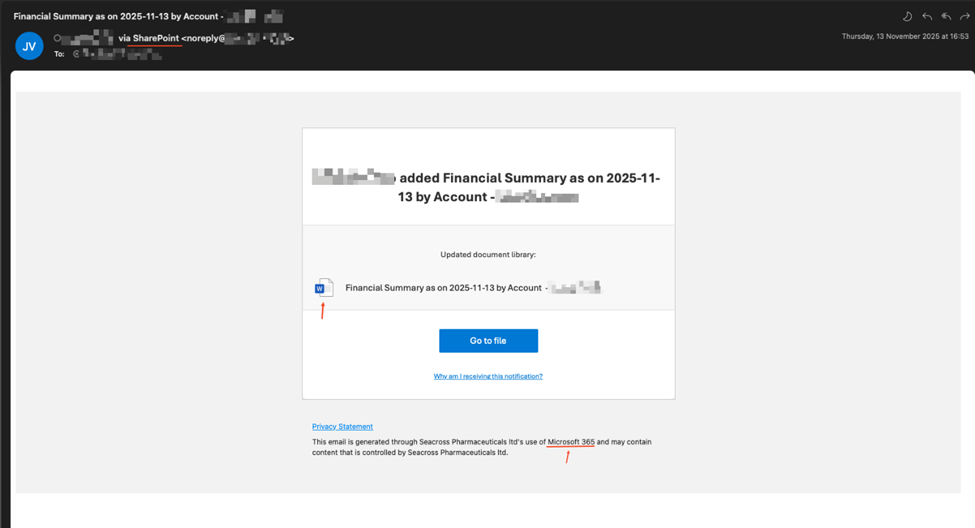

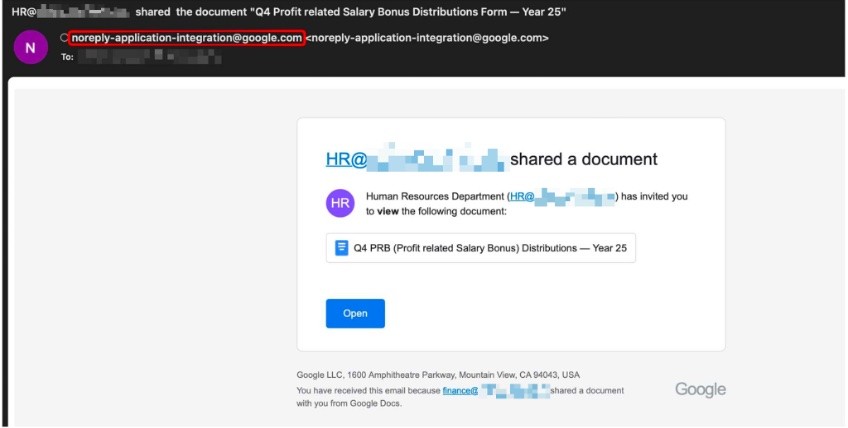

·第三,智能体特有攻击开始出现。攻击者尝试误导智能体访问内部系统、读取敏感文档,或在外部网页、文件中埋入隐藏指令,借助智能体对外部内容的信任机制实现“间接控制”。这些攻击不再依赖单一提示,而是嵌入到完整工作流中。

这意味着,企业在部署 AI 智能体时,面临的已不是“模型是否会胡说八道”,而是“整个系统是否会被引导做出危险行为”。

更具挑战性的是,传统安全体系往往是围绕网络、终端和应用接口建立的,而 AI 智能体带来了全新的变量:它既是“应用”,又是“执行主体”,还可能成为“权限中枢”。一旦安全策略仍停留在输入输出层面,就难以覆盖智能体复杂的决策与执行路径。

基于这些观察,Check Point 与 Lakera 在研究中提出了对 2026 年及未来企业部署 AI 智能体的六点关键启示,这也构成了企业构建安全体系的战略前提。

1.必须重新定义信任边界:在智能体时代,信任不再是“是否允许访问”的二元判断,而是要结合上下文、来源、目的与行为风险进行动态评估。智能体与用户、外部内容、内部系统之间的关系,本质上是一张持续变化的信任网络。

2.安全护栏需要从“规则型”升级为“智能型”:静态规则难以理解复杂语境,也难以判断真实意图。未来的安全防护必须具备上下文感知与行为推理能力,能够理解“这个请求为什么被发起、会导致什么后果”。

3.可审计性和透明度成为企业级 AI 的前提条件:如果企业无法还原智能体的决策路径、调用过哪些工具、访问过哪些数据,就无法对风险进行溯源,也无法满足合规和内控要求。

4.AI 安全必须纳入整体网络安全体系:智能体安全不应成为孤立模块,而应与身份管理、威胁情报、网络访问控制、数据防护协同运作,形成统一防御体系。

5.安全不再是功能组件,而是系统架构能力:是否具备“原生安全设计”的智能体架构,将直接决定其能否进入关键业务系统。

6.法规与合规将倒逼企业提前布局:随着 AI 监管不断完善,企业若缺乏可审计、可解释、可控的智能体体系,将在合规层面面临越来越高的风险。

在这一背景下,AI 智能体安全不再是“附加能力”,而成为企业是否能够放心部署智能体的决定性因素。

Check Point 与 Lakera 的结合,为企业提供了一种系统化应对路径。Lakera 作为专注于 AI 原生安全的厂商,其技术能够针对智能体场景识别系统提示词泄露、间接指令注入和工作流级攻击等新型威胁;而 Check Point 在传统网络安全领域积累的纵深防御体系,则为智能体提供了与企业整体安全架构融合的基础。

具体来看,这种能力组合体现在几个关键方面:

·上线前的实战演练(Red Teaming):在 Agent 部署前,利用 Lakera Gandalf 引擎进行自动化红队测试。Gandalf 拥有全球最大的 AI 对抗性测试数据库(包含数千万种攻击变体),它像一个不知疲倦的“黑客”,在上线前对 Agent 进行全方位的攻击测试,提前找出逻辑漏洞。

·运行时(Runtime)防御:针对“动态感知”的需求,Check Point 的解决方案与 Lakera会在运行时(Runtime)协同工作。不同于简单的关键词匹配,这种防御机制能够实时分析 AI 的意图和上下文。如果一个客服 Agent 突然试图调用财务 API,系统会立即识别出这一“意图异常”并拦截,从而解决“信任边界”模糊的问题。

·基于情报的数据清洗:依托 Check Point ThreatCloud AI 每天数十亿次的威胁情报分析能力,Infinity 平台确保 Agent 访问的每一个 URL、读取的每一个文件都经过清洗。这从源头上切断了“间接提示词注入”的路径,确保 AI 摄入的数据是“干净”的。

在人工智能大行其道的当下,AI 智能体的真正门槛并不在于模型能力本身,而在于企业是否具备让它“安全运行在生产系统中”的能力。如果安全体系无法跟上智能体的进化速度,再先进的功能也难以长期稳定发挥价值。因此,在 AI 智能体全面进入生产环境之前,需要考量的不只是算力与算法,更是一整套面向未来的安全架构能力。这既是风险防控问题,也是企业能否真正释放 AI 生产力的基础条件。

申请创业报道,分享创业好点子。点击此处,共同探讨创业新机遇!