有些事情我们一直在思考,比如搜索引擎是如何来判断文章的原创?文章是否有关键词堆积?那么搜索引擎又是如何来判断文章和关键词的相关性的呢?还有很多朋友都很疑惑的一个问题,因为大家都知道Google的排名算法PR,好像现在不起作用了,因为很多SEOER都跟我说,很多PR高的在某些关键词排名反而落后于PR值很低的站点。所以大部分的朋友认为是不是PR现在已经不起作用呢?

很多朋友对上面的问题都很疑惑,到底为什么通过什么原理或者是什么机制来判断这些问题的呢?其实就是我们今天要讲的一个原理,叫做LSI(Latent Semantic Index)翻译成中文的意思就是隐含语义索引。

隐含语义索引工作原理:

当蜘蛛爬取并下载站点页面后,隐藏语义索引(以下我们检查LSI)把下载网页的所有单词制作成一个列表,然后就是将一些没有语义的单词过滤(比如停用词,过滤词等),然后再将站点所有的页面都做出单词列表。然后利用这些列表就可以做一个以页面(文档)为X轴,单词为Y轴的巨型矩阵。如果一个单词出现在某个页面,那么对于的页面位置我们标为1,反之就为0。这样就可以很清晰的看到每个单词在整站页面出现的频率。

当然仅仅是靠这样是不能准确的技术的,那么LSI将引入一个关键词权重。1.关键词在页面出现的频率越高这个关键词在这个页面的权重就越高。2.就是整站关键词频率高的权重越低。

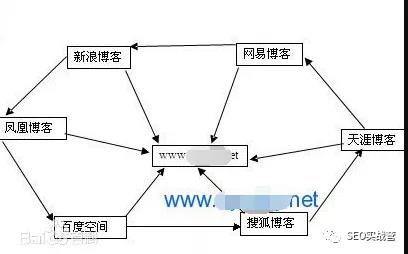

LSI最重要的是可以算出站点某个关键词的相关关键词在其他内页的出现的频率。这样的好处就是即使你的某个站点页面未出现你搜索的关键词,也可能将相关的页面搜索出来。所以如果你做某个关键词排名还是把你所有的反向链接都用该关键词作为锚文本的话,那么你的反向链接的质量度会下降,就是LSI的作用。还有就是你站点页面做相关的长尾关键词相互提升其竞争力,就是因为他们的相关性。所以如果你还是用以前的方法来做优化,不做长尾关键词,不做相关性的话,那么你的站点关键词是很难获得很好的排名的。

从上面的叙述的原理我们不难看出,为什么搜索引擎能够表现出这么好的智能,虽然LSI并不是理解某个单词的意思,但是他通过计算一个页面包含的关键词,并且参考其他网页所包含的关键词组成。所以LSI会得出一个结论,具有很多关键词相同的网页,他们的页面内容也是接近的。所以这就是为什么搜索引擎能够很多的判断伪原创和采集的页面的文章,所以你不要因为你改改标题,改改某些段落搜索引擎就不知道了。其实LSI就能够很好的判断。

这就是LSI的智能结果。

那么我们链接LSI以后我们再来回答文章开通的一些问题,前几个问题就不用回答了,关于PR值现在是否起作用的问题,我的回答是否定的。PR算法现在还是Google的核心算法,现在没有变,以后也只是不断改进,也不会变。那为什么会出现PR低的站点关键词排名还比PR高的排前面呢?你要知道PR的算法,Google计算一个页面的PR值是计算其所有的导入链接,包括内链。但是Google更加看重那些具有相关性网站和页面过来的链接,而对不相关的反向链接在最后计算网页关键词排名的时候不会起作用。但是这些不想关的反向链接在计算PageRank是还是有用的,所以就会出现这种现状。PR高的关键词排名排在PR低的下面。

那么如何来分析反向链接的相关性呢?就是前面我们说的LSI。

PS:搜索引擎并不是那么不可接近,他的想法也和站长是一样的,目的就是为了让用户有更好的体验。我们研究它并不是要去迎合他的口味。而是和搜索引擎一起去赢得用户的青睐。所以无论何时你都不要忘记站点用户体验 (UEO)转载请注明来源,谢谢

申请创业报道,分享创业好点子。点击此处,共同探讨创业新机遇!