很多站长常常为网站不收录或收录不理想而烦劳,更有些许人直接报以“度娘脑残”这种心态对之,殊不知站点收录是否是掌握在自己手中。今天和大家交流下关于网站收录的几点,前锋经验之谈,欢迎交流,qq281336241。

1、内容质量过的去,保持稳定更新。所谓天下文章一大抄,再加上汉语言的博大精深,一句话可以翻译成十句话。特别是个人站长,搞个博客全原创还差不多,但是搞个别的站也全原创就有点难度,前锋觉得也没那必要。伪原创的文章,再加上相对的“守时守量”的更新,这是收录的第一道关卡。这里说相对,就是自然点。守时守量就是更新的时间和数量。

2、打造通畅的网站内部结构。在之前谈内部链接的时候,前锋也说了,良好的内部链接结构,不仅能使网站整体权重合理分配,同时提高网站页面被收录的几率。内部链接体现在收录方面最主要的就是蜘蛛爬行障碍,虽然百度优化指南上指出,蜘蛛爬行和用户访问一致,这话很官方的,不可全信。合理迎合蜘蛛进行爬行,这可不算作弊。

3、合理的url结构。都说现在搜索引擎即使已不在乎动态url和静态url了,但前锋觉得简洁的url较之动态url容易被搜索引擎收录。当我们优化一个相对大点的平台,就很容易发现这点。下面两种url结构,很明显第一种容易被收录,而这种情况数量扩充至10000,你会选择哪种url方式?!

4、查看蜘蛛访问日志,检查爬行状态和爬行页面。检查爬行状态就不用多说了,主要看返回状态码,200、301、404等等。检查爬行页面,查看它每天主要爬行的是哪些页面?而这些是否是你想要它爬行的页面?站长都知道蜘蛛爬行你网站的次数和时间在网站权重不变的情况是差不多的,也就说如果你网站存在蜘蛛陷阱,那么会大大蜘蛛的爬行效率。有一种常见的情况,就是组合筛选条件。这些组合筛选条件会产生巨量页面,而这里面很多页面并没有实际内容。这样蜘蛛爬行大量过滤条件页面,大大浪费爬行时间而造成有用页面收录机会下降。同时由于这些页面本身没什么时间内容或重复内容,使得即使爬行也不被收录。

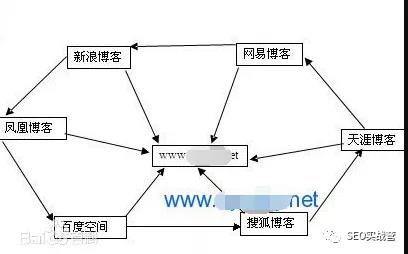

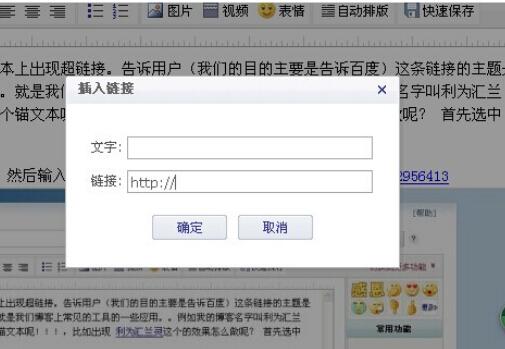

5、外部链接对页面的权重传递。外部链接能够很好的引导蜘蛛去爬行目标页面,而且传递权重去目标页面,提高目标页面的排名能力。这里不仅仅是提高某个单页面的收录几率,而是提高一类的页面。

说的再多看的再多,顶多算个理论知识,纸上谈兵。最重要的是检查实践,具体情况具体分析处理。本文由经典语录www.nzshop.net站长原创,转载请注明出处,谢谢~

申请创业报道,分享创业好点子。点击此处,共同探讨创业新机遇!