进入AIGC时代,智算中心规模日渐庞大,服务器能耗与日俱增。如何降低智算中心能耗已成为国家和地方政府关注的焦点。

工信部数据显示,2022年全国数据中心总耗电量约2700亿千瓦时。当前,大部分数据中心仍主要采用风冷散热技术,在单柜密度、PUE值方面已愈发难以满足行业发展及绿色节能方面的要求,而冷板式液冷方案则为现有数据中心节能改造提供了诸多便利。

近日,国产CPU领军企业飞腾信息技术有限公司正式发布飞腾腾云S5000C服务器液冷解决方案,并在第十二届中国电子信息博览会上荣获创新金奖。

液冷释放芯片极致性能

目前,常规风冷仅支持8-10kW的单柜密度,若继续采用风冷散热,将导致行间空调需求数量陡增,算力成本也将急剧增加,因此高密度散热场景下液冷方案成本和性能优势显著。本次飞腾联合同泰怡针对S5000C服务器液冷解决方案进行测试,结果表明基于本次液冷解决方案打造的下一代高性能液冷服务器,如果应用在30KW风液式CDU液冷机柜中,单机柜可配置25台1U双路液冷服务器,相对风冷机柜理论上可提升297.6%。

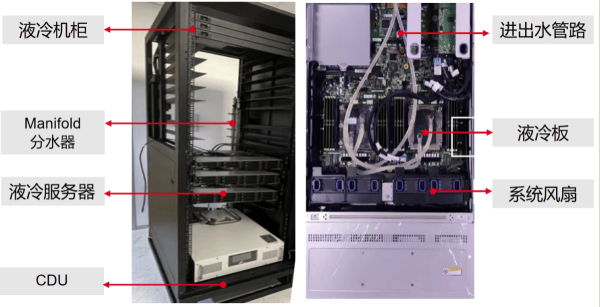

30KW 风液式液冷机柜

测试结果还表明, S5000C高主频芯片可以在液冷系统的加持下稳定可靠运行,主频相对标准版芯片提高20%。

液冷实现算力绿色节能

中国信息通信研究院测算,到2030年我国数据中心耗电量将达到5900亿千瓦时。工信部等部门在2021年12月提出加快绿色数据中心建设,到2025年全国新建大型、超大型数据中心电能利用效率(PUE)降到1.3以下。

相较于传统风冷,液冷方案采用液态介质作为热传递介质,热传导效率比空气大大提高,可以更有效地移除计算机组件中的热量,从而降低能耗。本次测试结果表明,液冷系统的整体能耗相较风冷可降低约10%左右,同时满足国家要求的PUE值,从而降低空调机房以及机柜的电力成本,具有较好的经济适用性。

飞腾腾云S5000C液冷机柜以及服务器结构图

此外,本次飞腾推出的液冷解决方案基于四台双路服务器进行系统功耗测试,进液温度在40℃以上, S5000C结温控制在65℃以内,CPU的结温温度波动在±1℃以内,使得服务器系统的核心部件在一个较低且稳定的温度下运行,大大提高了系统的可靠性以及核心部件的使用寿命。整个液冷系统热阻低,散热能力显著加强。

为了最大限度降低漏液带来的风险,本次飞腾液冷解决方案还采用了一套漏液感知与干预系统。通过漏液检测接口直接检测漏液,在第一时间通过BMC发送警报。在本次测试中,飞腾针对主板的LEAKAGE 4pin 漏液检测接口进行了测试,目前该接口已通过漏液检测设备识别检测与移除告警以及模拟漏液故障报警等测试。

随着AI技术的飞速发展,液冷技术特别是冷板式液冷正获得越来越多数据中心的青睐。由于冷板式液冷的硬盘、光模块等服务器部件以及运维模式和机房承重与传统风冷场景基本一致,因此不需要对现有风冷机房和机柜进行大规模改造,升级成本也相对较低。飞腾本次发布的飞腾腾云S5000C服务器液冷解决方案不仅能够显著提升数据中心的能效和散热性能,还能够降低噪音和运营成本,这对于追求高效率和可持续运营的数据中心来说至关重要。

申请创业报道,分享创业好点子。点击此处,共同探讨创业新机遇!

2026年刚开年,全世界最狂的那个男人,穿着他的经典黑皮衣,在CES舞台上发出了未来十年的信号。他搞了个“能吃饱套餐”:6个包子+一碟小菜+一碗粥=肉包子套餐,这样以后你只要买一个套餐就能吃饱了。(Rubin平台)同时他们店里还免费提供的筷子、勺子、蘸料、酱油、醋、水果、零食等等。(开放10万亿语言

12月12日-14日,2025全球开发者先锋大会暨国际具身智能技能大赛(GDPS2025)于上海张江科学会堂举行,大会以具身智能竞技为核心,融合了技术比拼、产业展示与科普体验,为全球观众呈现出具身智能的现在与未来。上海开普勒机器人有限公司(以下简称"开普勒机器人")携明星产品K2"大黄蜂"亮相,并参

在数字化与智能化深度交织的时代浪潮中,安全的边界不断延展,技术的演进正引领产业迈向新一轮变革。10月24日,以“弈动Dynamic·数智跃迁博弈无界”为主题的2025TechWorld智慧安全大会在北京盛大召开。来自国家部委、院士学者、高校科研机构和企业的权威专家与业界精英齐聚北京,共议AI安全、数

2025年10月25日,2025世界青年科学家峰会之人工智能(AI)融合创新发展论坛在浙江温州成功举办。本次论坛由国际院士科创中心主办,中国投资协会能源投资专业委员会、温港院士科创中心承办,中国电工技术学会、中科先进技术温州研究院与温州市电力工程学会提供支持,以“瓯江论道-AI赋能绿色发展”为主题,

我觉得我们AI的目标是:从芯片设计到软件生态,全链路自主开发,建立可控的世界级AI体系。所以这是俺对未来5年中国AI圈的展望和判断。(1)2026年,英伟达造车、国产开车26年国产芯片会在推理和垂直场景上发力。以DeepSeek为代表,大多数AI大模型会以软件弥补硬件不足,所以训练和推理分开,训练就

文/道哥在深陷“后门”风波、接受网信办问询之后,英伟达的“特供版”H20芯片,又有了新消息。近日,美国科技媒体《TheInformation》援引知情人士消息称,英伟达已悄然向其关键供应商——包括负责封装的安靠科技、供应高带宽内存的三星电子、以及承担后端处理的富士康发出指令,要求暂停所有与H20AI

文/二风来源/节点财经一场关于“中国芯”的IPO审议,正把投资者们的目光锁定在上交所。根据上交所发布的公告,上市审核委员会已定于9月26日审议摩尔线程的科创板首发申请。作为中国半导体自主化浪潮中最受瞩目的“考生”之一,包括其创始人显赫的英伟达背景、高达80亿元人民币的募资雄心,以及在国产GPU领域取

技术的进步永无止境,继创下TPC-C性能&性价比双冠之后,阿里云PolarDB云原生数据库再度实现关键突破。9月24日杭州云栖大会上,阿里云宣布推出全球首款基于CXL(ComputeExpressLink)2.0Switch技术的PolarDB数据库专用服务器。在原有RDMA网络的基础上,Polar